NutriSight, rendre les informations nutritionnelles plus accessibles

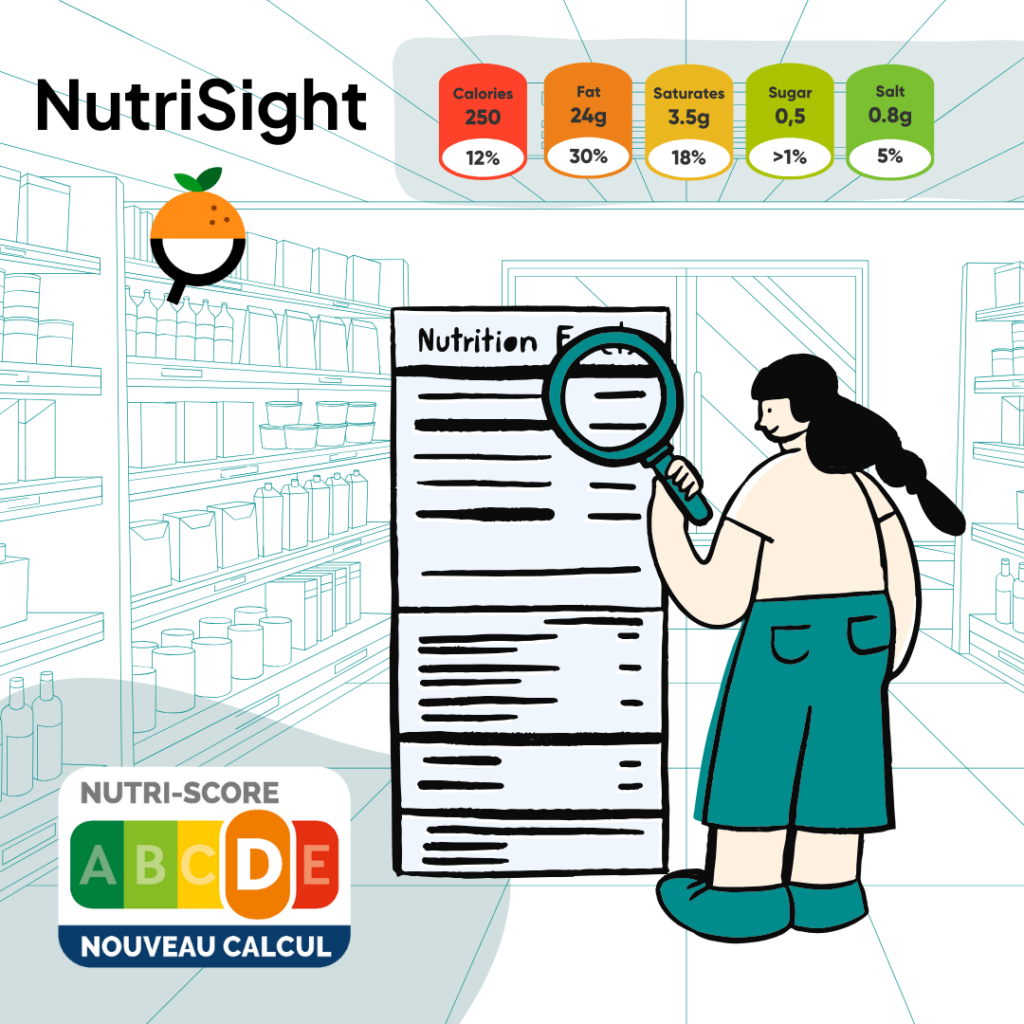

La nutrition est un des indicateurs clé de notre alimentation. Certains vont se pencher en particulier sur certains indicateurs: sucre ou glucides, calories ou gras selon leurs préoccupations. Le Nutri-Score se distingue car il tente d’en donner un aperçu global et équilibré en le couplant à d’autres éléments.

Une chance, c’est que les informations de nutrition sont, dans la plupart des pays, obligatoires sur l’emballage des aliments transformés.

La nutrition, une information capitale pour nos choix alimentaires

Toutefois, si l’on veut pouvoir comparer les aliments entre eux, calculer le Nutri-Score sur les produits où il est absent ou encore surveiller des apports journaliers, il faut avoir les informations nutritionnelles dans une base de données. Et c’est justement dans ce cadre qu’est né le projet Open Food Facts.

Mais passer de l’information imprimée sur l’emballage à une information dans la base de données n’est pas une si mince affaire et demande de s’activer pendant plusieurs minutes sur son téléphone avec une bonne concentration. Multipliez cet effort par 3,7 million de produits, ajouter que cette information change souvent, et vous comprendrez que même pour un projet comme Open Food Facts avec de nombreux contributeurs motivés, ça reste un sacré défi.

Accélérer l’accès à cette information

Heureusement les techniques de reconnaissance d’images peuvent nous aider. C’est ce que l’équipe “Intelligence Artificielle” de Open Food Facts s’était dit depuis quelques années déjà. Hélas plusieurs tentatives menées par des bénévoles ont échoué. Le problème ne se laissait pas résoudre si simplement. Entre la diversité de langues, de formats, la qualité des images, les emballages incurvés et j’en passe, la tâche était bien plus ardue que prévu.

Mais le programme DRG4Food, financé par la commission Européenne, nous a donné l’occasion de changer la donne. Ce programme auquel nous avons soumis notre projet, NutriSight, nous a donné l’opportunité de développer un nouveau modèle s’appuyant sur les récentes avancées du domaine de la reconnaissance d’images.

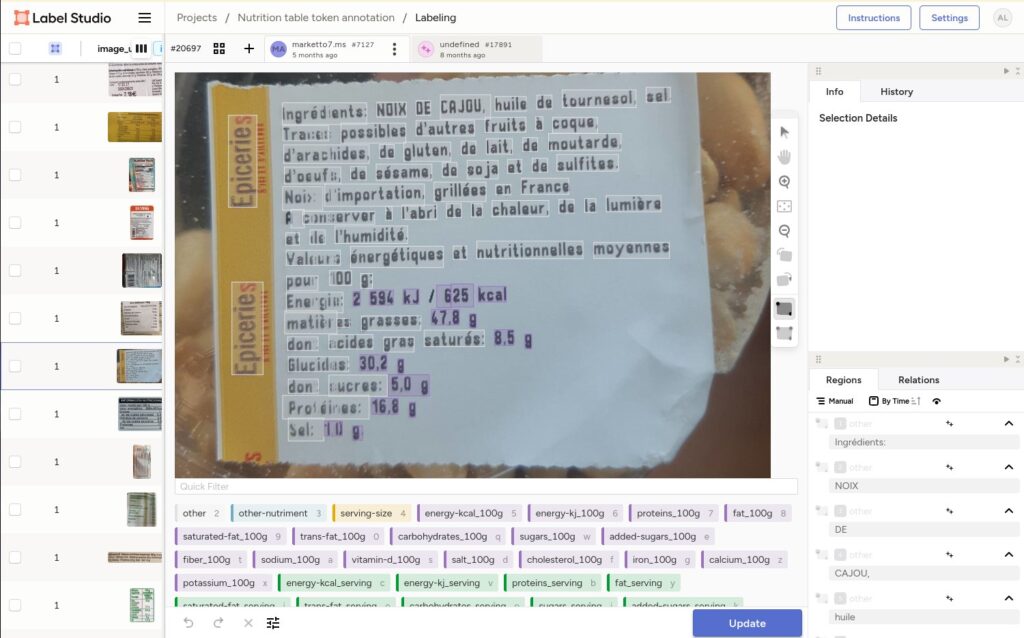

En association avec l’application GoCoCo, qui utilise les données de notre base ouverte, nous avons annoté de nombreuses images, puis nous avons développé un modèle capable d’extraire les données de nutrition avec une grande précision.

Bien sûr, dans l’esprit de notre projet, tout ceci est Open Source, de la donnée d’entraînement, au modèle et au code pour le déployer.

Grâce à ce nouvel outil nous espérons pouvoir toujours plus augmenter et mettre à jour l’information sur de nombreux produits alimentaires. Ceci permet d’augmenter la transparence, support de choix plus éclairés au service de la santé.

Comment s’impliquer

✔️ Si vous êtes un utilisateur de l’application Open Food Facts vous bénéficierez bientôt de ces outils de prédiction dans l’application mobile et sur le site web.

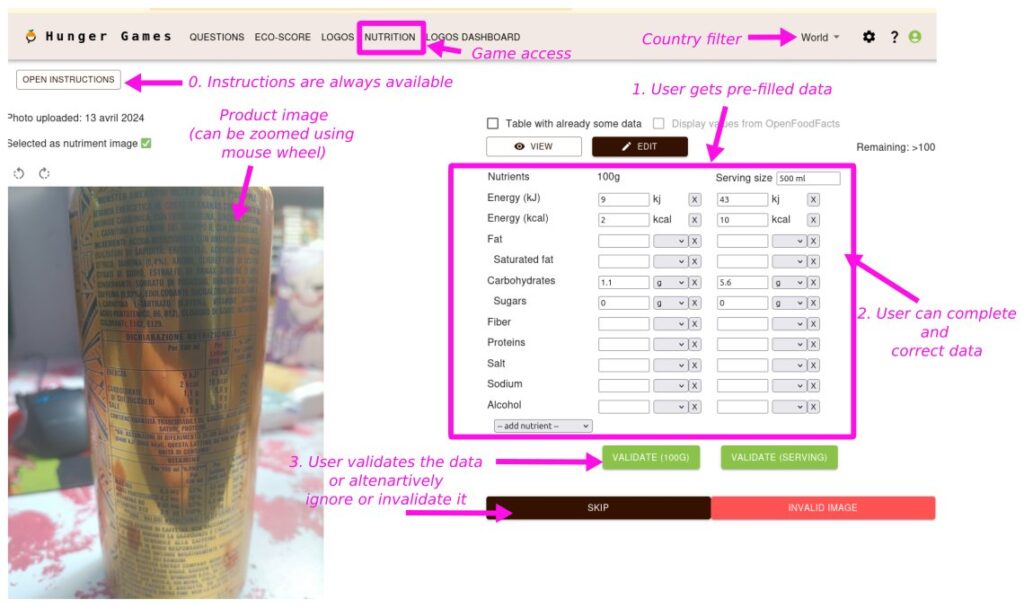

✔️ Si vous êtes un contributeur à la base de données, vous pouvez même utiliser la plateforme Hunger Games pour valider rapidement les informations nutritionnelles de plein de produits alimentaires.

✔️ Si vous êtes un ré-utilisateur des données Open Food Facts, vous pouvez intégrer ce modèle à votre application en utilisant l’API de robotoff dédiée (voir aussi l’introduction) et en intégrant éventuellement le web-component à peine développé pour valider les informations. Vous pouvez même imaginer déployer le modèle sur vos propres serveurs.

✔️ Si vous êtes un expert en science des données (data scientist), vous pouvez décider de nous aider à améliorer le modèle, à l’étendre à plus de données où à le rendre disponible sur mobile. vous serez certainement intéressé par le modèle, les données, ou le code d’entraînement.

Encore un grand merci au projet DRG4Food, financé par la commission européenne, qui nous a donné l’opportunité d’accélérer la course vers plus de transparence dans l’alimentation.

Comments: 1

[…] la première partie de cette série d’articles de blog Nutri-Sight, nous avons présenté Nutri-Sight, notre solution d’IA développée grâce au programme […]

Comments are closed.